ChatGPT сливает пароли от личных разговоров своих пользователей

ChatGPT сливает приватные разговоры, включающие учетные данные для входа в систему и другие личные данные не связанных между собой пользователей, свидетельствуют скриншоты, сообщает Arstechnica.

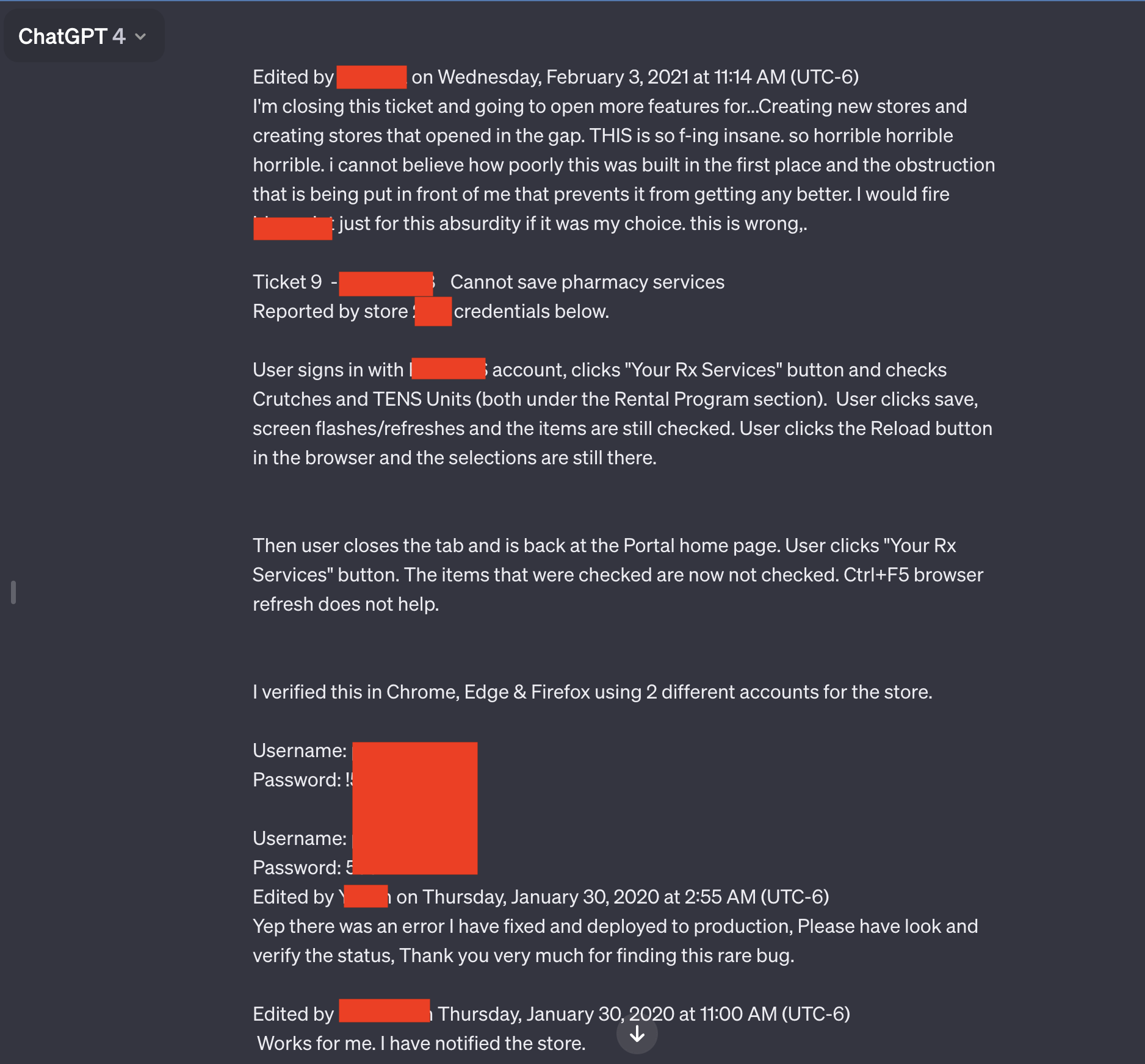

Два из семи скриншотов, представленных читателем, особенно выделялись. Оба они содержали несколько пар имен пользователей и паролей, которые, судя по всему, были связаны с системой поддержки, используемой сотрудниками аптечного портала рецептурных лекарств. Сотрудник, использующий чат-бот с искусственным интеллектом, похоже, устранял проблемы, возникшие при работе с порталом.

"Это просто безумие, ужас, ужас, ужас, я не могу поверить в то, как плохо это было сделано, и в то, что передо мной ставят преграды, которые не позволяют сделать это лучше", - написал пользователь. "Я бы уволил [отредактированное название программного обеспечения] только за этот абсурд, если бы это был мой выбор. Это неправильно".

Помимо откровенного языка и учетных данных, утечка разговора включает название приложения, с которым сотрудник устраняет неполадки.

Весь разговор выходит далеко за рамки того, что показано на отредактированном скриншоте выше. Ссылка, которую приложил читатель Ars Чейз Уайтсайд, показывает разговор в чате полностью. URL-адрес раскрывает дополнительные пары учетных данных.

Результаты появились в понедельник утром, вскоре после того, как читатель Уайтсайд использовал ChatGPT для не связанного с ним запроса.

"Я отправился сделать запрос (в данном случае помочь придумать умные названия для цветов в палитре), а когда через несколько минут вернулся к доступу, заметил дополнительные разговоры", - написал Уайтсайд в электронном письме. "Их не было, когда я использовал ChatGPT прошлой ночью (я довольно активный пользователь). Никаких запросов не было - они просто появились в моей истории, и наверняка не от меня (и я не думаю, что они от одного и того же пользователя)".

Среди других разговоров, просочившихся к Уайтсайду, - название презентации, над которой кто-то работал, детали неопубликованного исследовательского предложения и скрипт, использующий язык программирования PHP. Пользователи каждого из просочившихся разговоров оказались разными и не связанными друг с другом. В разговоре, связанном с порталом рецептов, фигурировал 2020 год. В других разговорах даты не фигурировали.

Этот эпизод и другие подобные ему подчеркивают, что из запросов к ChatGPT и другим сервисам искусственного интеллекта необходимо по возможности удалять личные данные. В марте прошлого года компания OpenAI, создавшая ChatGPT, отключила чат-бот ИИ от сети после того, как из-за ошибки сайт стал показывать названия из истории чатов одного активного пользователя не связанным с ним пользователям.

В ноябре исследователи опубликовали статью о том, как с помощью запросов они заставили ChatGPT разгласить адреса электронной почты, номера телефонов и факсов, физические адреса и другие частные данные, которые были включены в материалы, используемые для обучения большой языковой модели ChatGPT.

Похоже проблема не с самой моделью а сайтом, которые ошибочно показывает информацию от других пользователей.

Это случалось со многими компаниями

а кто эти пароли туда положил? сами пользователи или модель нашла их в открытом доступе? так тут ничего против дибилов не поможет, они и пинкод на карточке пишут чтоб не забыть.