Nvidia - самый мощный чип в мире и роботы наступают

Пока cтоимость NVIDIA превысила ВВП России, а сама Нвидиа вошла в топ 3 самых дорогих компаний мира..:

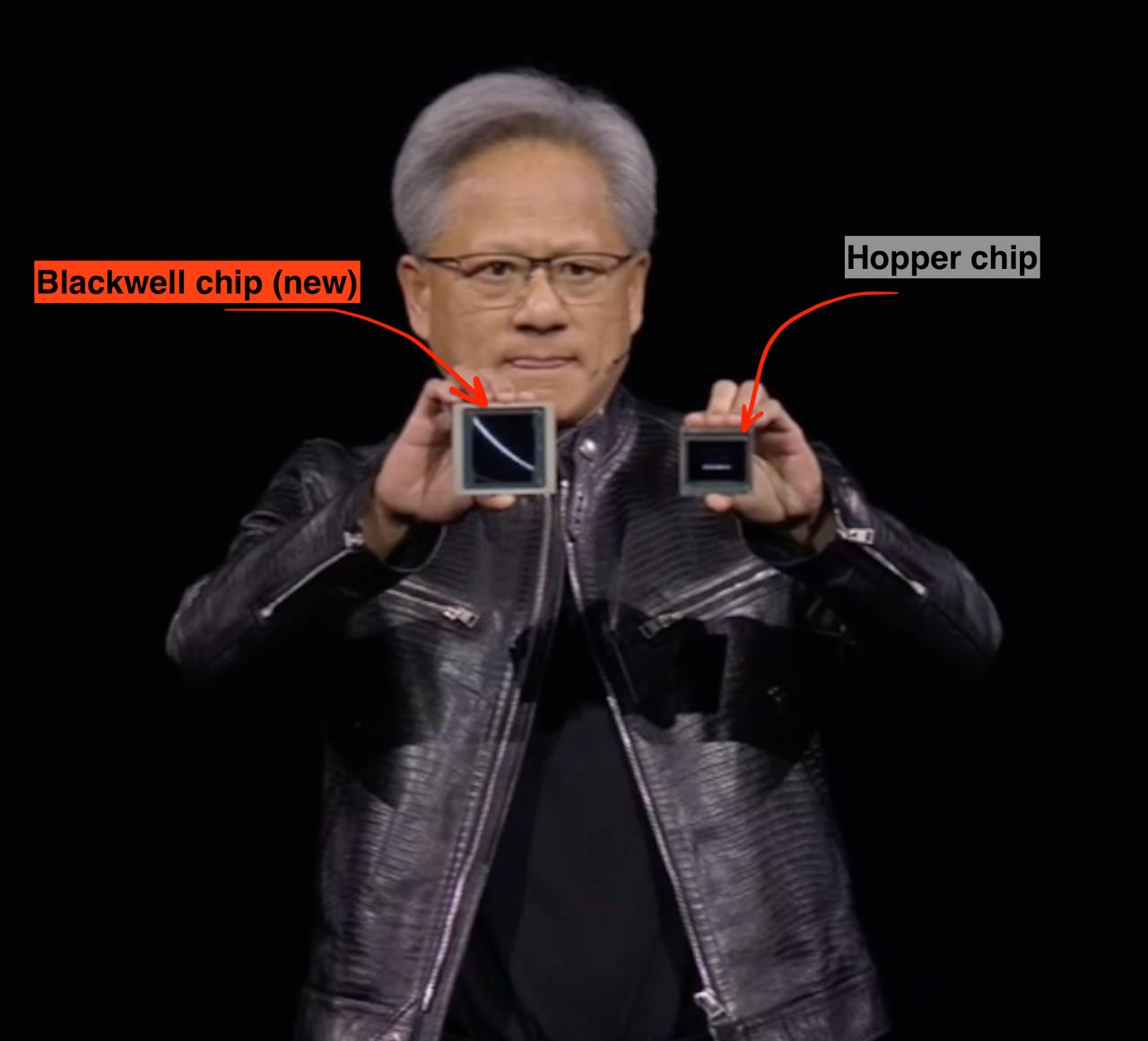

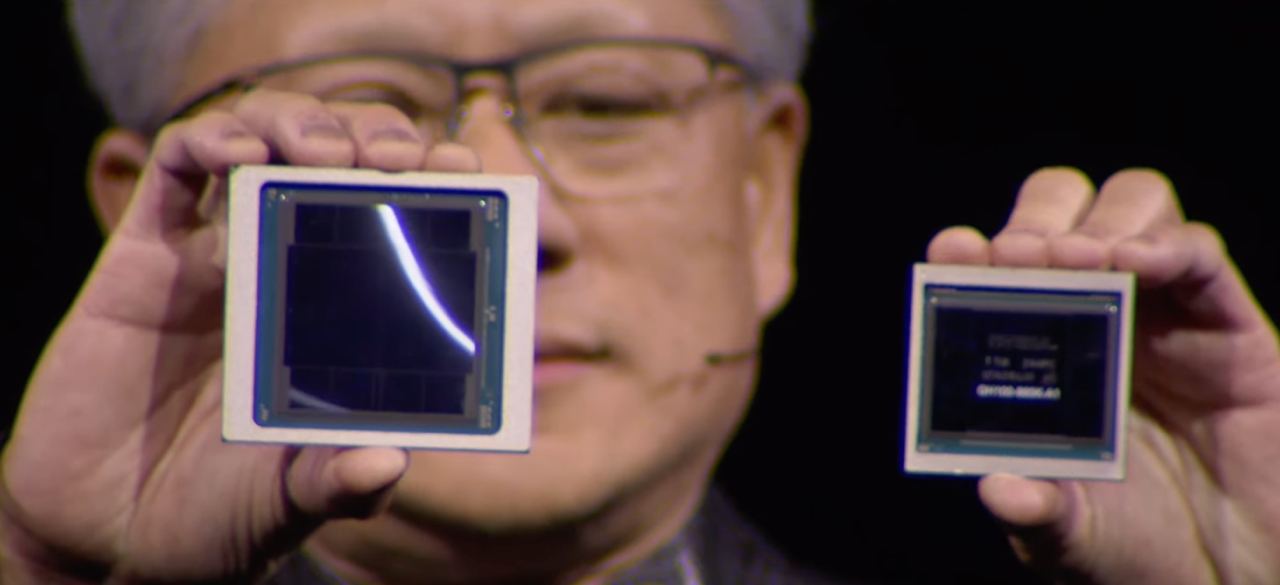

Они выкатили новые монстры для AI: Blackwell B200 GPU и GB200 "суперчип"

Как всегда бывает на презентациях NVIDIA, слово "быстро" - это вчерашний день.

Nvidia показывает новую GPU для GenAI

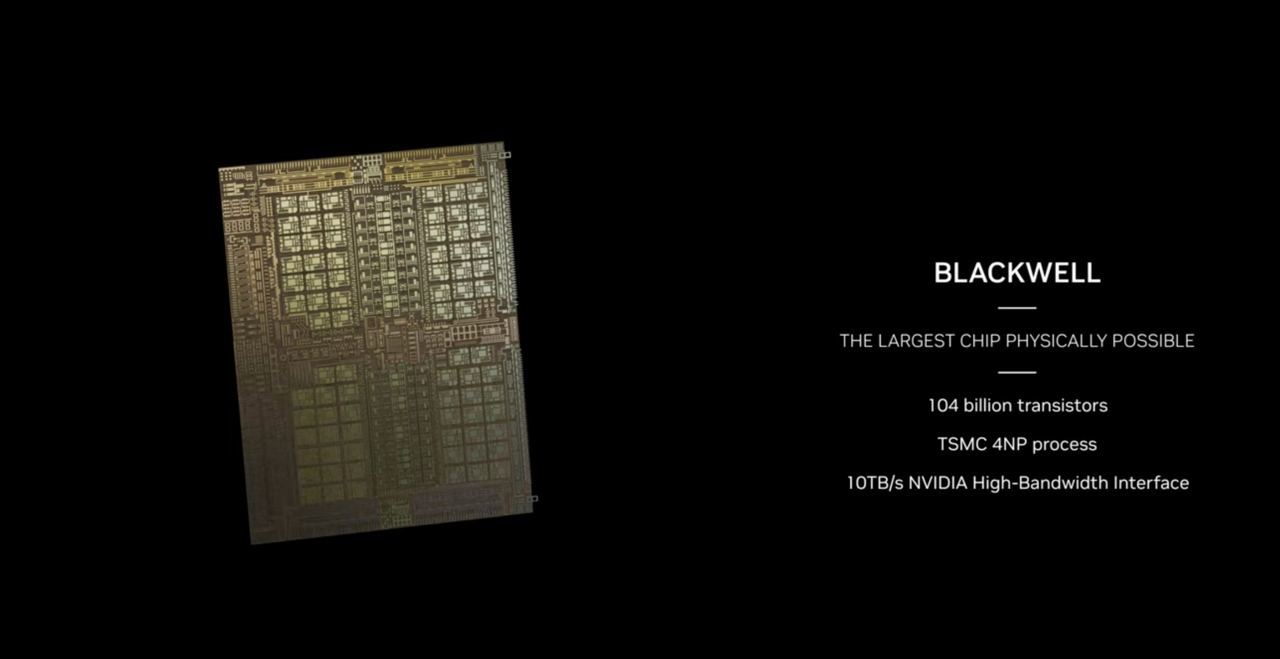

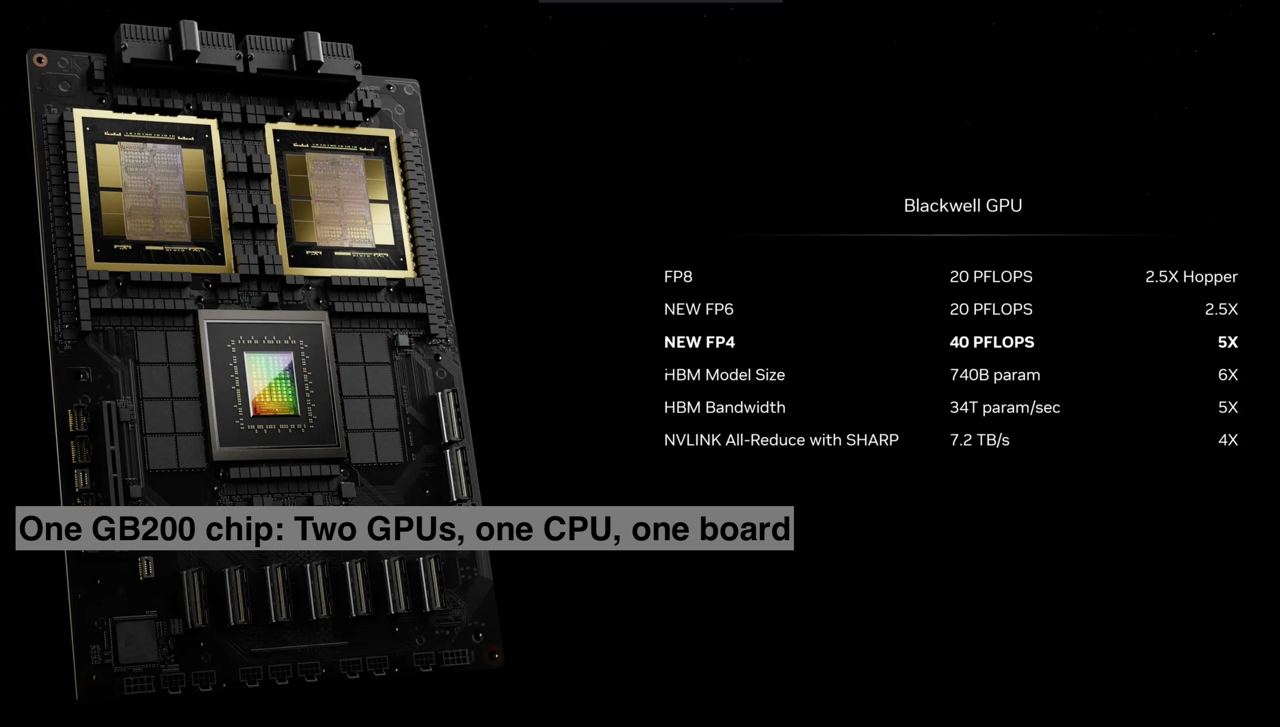

2 чипа в одной «карте» (в кавычках потому, что у каждой карты свой процессор, отдельная память, это мини-мини-компьютер).

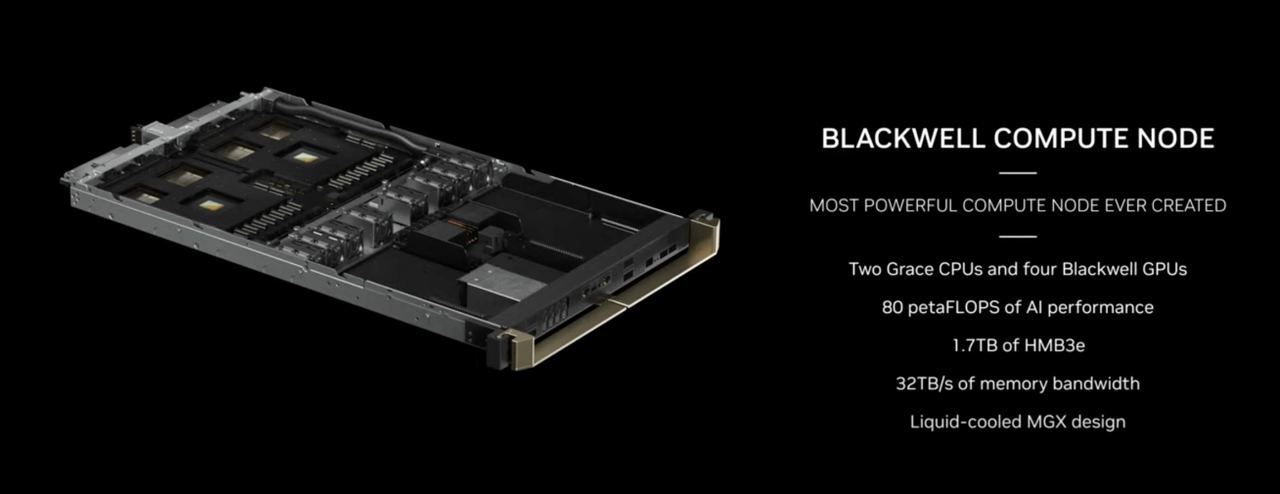

А вот так выглядит сам суперчип GB200.

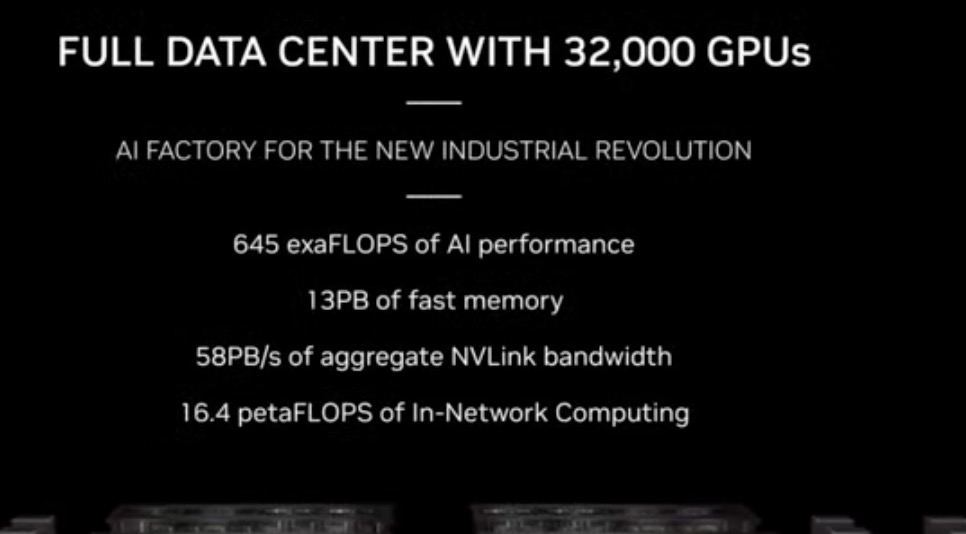

CEO говорит, что там чуть ли не вся стойка (NVL72) — это одна большая GPU, которая воспринимается как один девайс, но пока не ясно, что это означает на практике.

Прокачали Transformer Engine до v2, теперь он лучше работает с Mixed Precision. Поскольку все модели теперь — трансформеры, то это должно давать существенный прирост на широком спектре задач.

Поддерживается FP4 / FP6 для сохранения памяти. По скорости вычислений пока не ясно, ускоряются ли они относительно 8-битных. В FP4 скорость вычислений на каждом чипе в 5 раз быстрее, чем в FP8 на прошлом поколении.

Жидкостная система охлаждения, 2 литра в секунду пропускает через себя один DGX (Compute Node на картинках). Не знаю зачем вам эта информация

Для сравнения привели цифры тренировки модели, сравнимой с GPT-4.

На старых картах: нужно 8000 H100 на 90 дней, мощность 15MW

На новых: 2000 карт B100, тоже 90 дней, мощность 4MW (то есть существенно экономит электроэнергию)

ЕЩЕ?

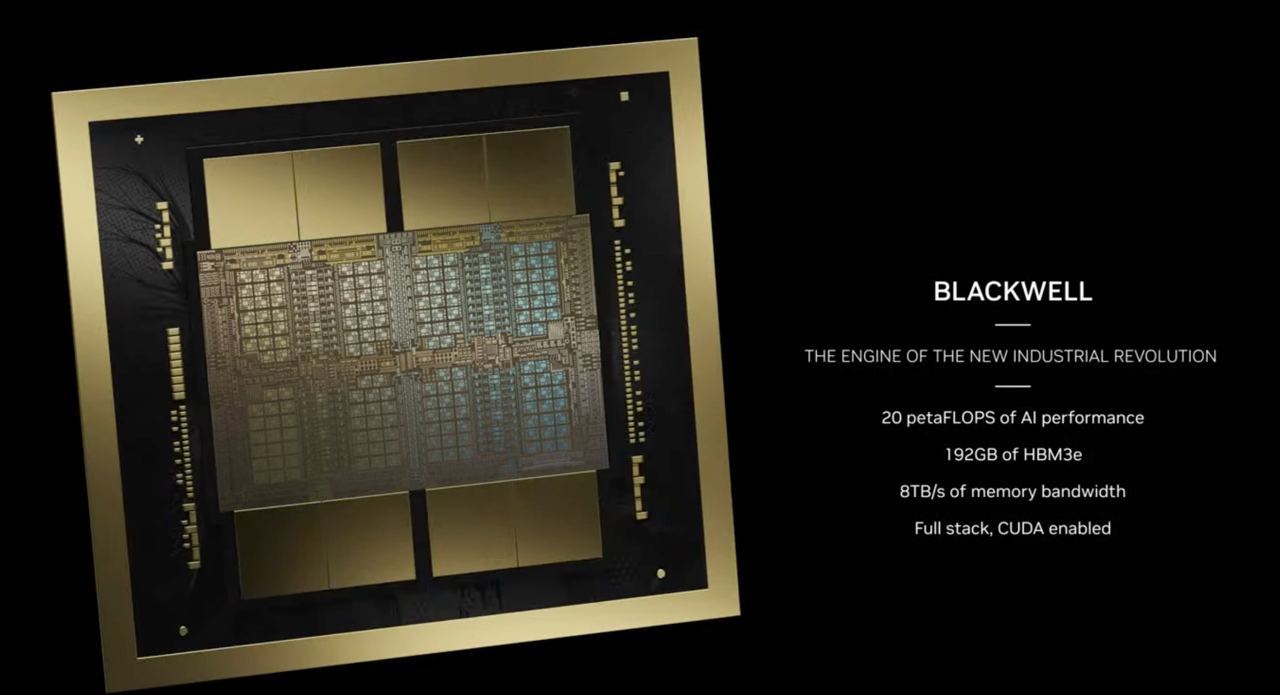

B200 GPU обещает до 20 петафлопс производительности в FP4 и 208 миллиардов транзисторов. Ваша GTX 1080 Ti нервно курит в сторонке.

В одной B200 будет 192GB памяти с пропускной способностью 8 ТБ/с. Идеально для LLM моделей, которые жрут память как не в себя и требуют большую пропускную способность.

GB200 "суперчип" объединяет 2 таких B200 GPU с одним Grace CPU (на ARM архитектуре). Nvidia хвастается, что это в 30 раз производительнее для инференса в LLM в FP4 по сравнению с H100.

Ключевая фишка - второе поколение трансформерного движка, который удваивает вычислительную мощность, пропускную способность и размер модели. Но хз, какая потеря точности будет после конвертации в FP4.

Nvidia утверждает, что GB200 снижает стоимость и энергопотребление в 25 раз по сравнению с H100 (опять же, в FP4).

Теперь будет поддерживаться и новый формат - FP6, золотая середина по скорости и точности между FP4 и FP8. Но бенчмарков не показали.

FP64 на уровне 45 терафлопс на GPU (против 60 у H100). Для нейронок double precision не релевантен, поэтому они особо и не парятся ускорять тут.

Тренировка GPT-MoE с 1.8 триллиона параметров (читай GPT-4) требовала 90 дней на 8,000 GH100 и 15МВт энергии. Теперь достаточно 2,000 GB200 и 4МВт. То есть во время тренировки 1x GB200 примерно в 4 раза быстрее чем 1x H100.

На инференсе GPT-3 с 175 млрд параметров, GB200 "всего" в 7 раз быстрее H100. Ну ладно, не все сразу.

Но не радуйтесь раньше времени - цены будут ядреными! Если H100 стоит около $40k, то GB200 будет минимум в 4-5 раз дороже.

Да и не достать их будет простым смертным. Первыми их получат Amazon, Google, Microsoft и Oracle. Известно, что Амазон уже планирует кластер на 20,000 GB200. А потребительские версии Blackwell ожидаются не раньше 2025 г.

ТЕПЕРЬ ПРО РОБОТОВ:

Дженсен Чел в кожаной куртке Хуанг: “ChatGPT момент для роботов может быть уже за углом”

На вчерашнем ивенте Дженcен Хуанг, CEO Nvidia, представил новые GPU, а также анонсировал GR00T - Generalist Robot 00 Technology.

GR00T (отсылка к Марвелу) позиционируется как foundation модель для будущих роботов, от простых манипуляторов до робо-гуманоидов. Моделька способна обрабатывать мультимодальные данные, такие как видео, текст и другие сенсоры, выдавая действия робота в ответ на различные ситуации. В придачу с ним можно разговаривать и голосом – LLM-ка все осилит. Кроме того, GR00T может обучаться эмулировать действия, наблюдая за человеком.

Однако данных для тренировки таких роботов не наберешься, как я уже говорил, например здесь. Поэтому Nvidia представила обновленный Isaac Lab – среду для обучения роботов c помощью RL в симуляции, максимально приближенной к реальному миру.

Так например натренировали Isaac Manipulator – это умная роборука. Эта штука может выполнять простые задания получая на вход текстовые указания и на лету адаптироваться к изменяющимся условиям, находя новое решение для задачи. Скоро на заводах тоже пройдут лэйофы, ведь люди больше не будут нужны : )

А гоняется моделька GR00T на мобильном GPU-чипе Jetson Thor (800 TFlops в FP8), специально разработанном для управления роботом с минимальной задержкой.

Похоже, Nvidia хорошо так притопила в разработке роботов. В ближайший год стоит ждать больше и больше новостей про умных гуманоидов.

Полное выступление (для тех, кто хочет на русском языке):

by эй ай ньюз и сиолошная

Чем лучше программисты, тем совершеннее ИИ. Чем совершеннее ИИ, тем меньше нужда в программистах.

А гуманоидные роботы это неизбывное стремление хумансов иметь рабов, чтоб не работать. И это не только физические роботы. ИИ тоже будет использован, чтоб не работать.

Отсюда, чем сильнее развивается ИИ, тем медленнее развивается человек. Вернее, развитие идет в другую сторону.

НУ наконецто дота и тетрис на минималках запустятся

«Не знаю зачем вам эта информация»

Это точно

если посмотреть на историю человечества, то первоначально общество (первобытно-общинное) было что-то сродни коммунизму-социализму: все работали бесплатно, столько сколько могли, добровольно, и все приносили в общую корзину.

На смену первобытному коммунизму пришло рабовладельчество.

История движется не по кругу, а по спирали. Т.е. повторяет саму себя, но не полностью

Вот и сейчас вместо капиталистического "социализма" человечество приближается к рабовладельчеству. Где рабы - это роботы и ИИ.

Что будет дальше - учите историю!